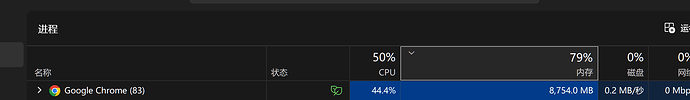

而且卡顿只对某些网站可以复现,让llm读了一下插件代码,等会请高人来看看有没有思路优化

从插件开发的架构和实现层面,针对 LLM 翻译导致的性能瓶颈,可以从以下几个核心维度进行深度优化:

- 引入异步处理架构 (Web Workers)

目前插件的大量正则匹配、HTML 解析和翻译文本比对可能都在 Content Script (主线程) 中执行。

- 优化方案:将不涉及直接 DOM 操作的逻辑(如 LLM 流式协议解析、文本预处理、多语言比对算法)迁移到 Web Worker

中。 - 效果:释放主线程,确保浏览器在处理翻译数据的同时,仍能以 60fps 响应用户的鼠标滚动和点击。

- 实施“渲染批处理”与“时间切片” (Scheduling)

流式输出(Streaming)最忌讳收到一个字符就更新一次 DOM。

- 优化方案:

- 缓冲更新 (Buffering):设置一个 100ms-200ms 的缓冲区,将 LLM 返回的多个片段合并后,再通过

requestAnimationFrame 发起一次 DOM 更新。 - 时间切片 (Time Slicing):如果一次性要插入大量翻译节点,使用类似 React Fiber

的思想,将任务分解为多个小任务,在浏览器空闲时 (requestIdleCallback) 逐个插入。

- 缓冲更新 (Buffering):设置一个 100ms-200ms 的缓冲区,将 LLM 返回的多个片段合并后,再通过

- 效果:将原本密集的重排(Reflow)变为有节奏的更新,大幅降低 CPU 瞬时负载。

- 基于视口的“懒渲染” (Intersection Observer)

如果页面很长,全量翻译会导致成千上万个 DOM 节点同时在后台更新,即便这些节点不在屏幕内。

- 优化方案:利用 IntersectionObserver API。

- 只有当原文节点进入视口(或即将进入)时,才触发翻译请求并挂载翻译 DOM。

- 对于离开视口较远的翻译节点,可以考虑暂时销毁或隐藏,以减轻浏览器的布局计算压力。

- 效果:将计算量从“整页规模”降至“屏幕规模”。

- 优化 DOM 挂载策略 (Containment)

插入翻译节点时,如果破坏了原有布局,会导致整个页面的重排。

- 优化方案:

- CSS Containment:为翻译后的容器添加 contain: layout; 或 contain:

content;。这会告诉浏览器,这个节点的内部变化不会影响外部布局。 - 固定占位:在翻译开始前,根据原文长度预估一个高度占位,避免翻译文本流式跳动时导致页面反复“震荡”。

- CSS Containment:为翻译后的容器添加 contain: layout; 或 contain:

- 效果:限制重排范围,防止“牵一发而动全身”。

- 减少 MutationObserver 的过度触发

由于插件本身会修改 DOM,这会再次触发它自己的 MutationObserver 监听。

- 优化方案:

- 在插件插入翻译节点时,通过一个全局标志位(Flag)暂时屏蔽监听,或者在监听器中通过 node.isTrusted

或特定属性过滤掉插件自己生成的节点。 - 提高 mutationChangeDelay 的动态阈值:当检测到用户正在高速滚动时,自动调大延迟或暂停扫描。

- 在插件插入翻译节点时,通过一个全局标志位(Flag)暂时屏蔽监听,或者在监听器中通过 node.isTrusted

- 流式输出的“增量更新”而非“全量替换”

- 优化方案:如果翻译节点是一个容器,流式更新时应仅追加文本节点,而不是每次都 innerHTML = …

重新构建内部结构。 - 效果:减少内存垃圾回收(GC)压力和 DOM 树解析开销。

总结

最有效的优化路径是:Web Worker 处理数据 → requestAnimationFrame 缓冲渲染 → IntersectionObserver

限制范围 → CSS contain 隔离布局。 这样可以将 LLM 的“重负载”与浏览器的“丝滑感”完美解耦。